UIUC 李博:如何探索大模型背后的安全隐忧?|ICML2024直击

大模型的安全研究能否跟上AI的发展速度?

近日,微软7月蓝屏事件再次引发了人们对AI安全性的关注。每一次新技术的诞生,都会带来新的责任和挑战。如果AI被集成到每一个应用程序中,那么类似微软蓝屏的事件也可能成为AI潜在的威胁。

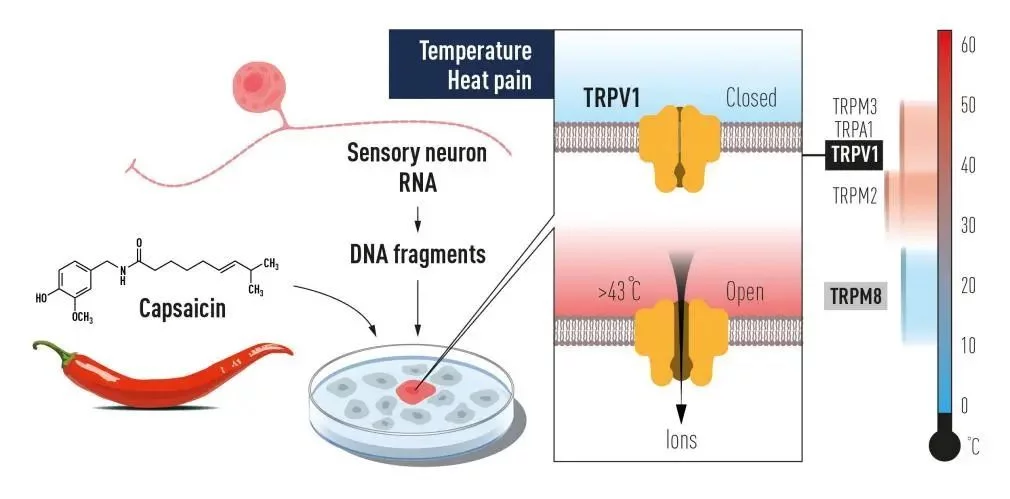

在ICML 2024大会上,AI科技评论采访了ICML Tutorial Chair李博教授。李博教授目前在伊利诺伊大学香槟分校(UIUC)和芝加哥大学任教,专注于机器学习、计算机安全、隐私和博弈论的研究。她指出:“大模型能力的提升并不意味着其安全性也得到了改进,我们仍需主动发现模型潜在的风险和漏洞。”

李博教授强调,尽管技术不断进步,但安全研究却未能同步跟上。她的研究团队正致力于开发更可靠的机器学习系统,以应对各种对抗性攻击的威胁。

此次事件提醒我们,AI的发展不仅仅是技术的进步,更是对安全性和稳定性的严峻考验。未来,如何平衡AI的技术创新与安全保障将成为一个重要课题。